Laura Hood|Politics Editor & Assistant Editor

Bir hastaneyi ziyaret ettiğinizde, yapay zeka (AI) modelleri, tıbbi görüntüleri analiz ederek veya geçmiş verilere dayalı olarak hasta sonuçlarını tahmin ederek doktorlara yardımcı olabilir. Bir işe başvurursanız, özgeçmişleri taramak, iş adaylarını sıralamak ve hatta ilk görüşmeleri yapmak için yapay zeka algoritmaları kullanılabilir. Netflix’te bir film izlemek istediğinizde, bir öneri algoritması, izleme alışkanlıklarınıza bağlı olarak hangi filmlerden keyif alacağınızı tahmin eder. Araba kullanırken bile, Waze ve Google Haritalar gibi navigasyon uygulamalarında tahmine dayalı algoritmalar iş başındadır, rotaları optimize eder ve daha hızlı seyahat sağlamak için trafik modellerini tahmin eder.

İşyerinde, ChatGPT ve GitHub Copilot gibi yapay zeka destekli araçlar, e-posta taslağı hazırlamak, kod yazmak ve tekrarlayan görevleri otomatikleştirmek için kullanılıyor ve araştırmalar, yapay zekanın 2030 yılına kadar çalışma saatlerinin %30’una kadarını otomatikleştirebileceğini gösteriyor.

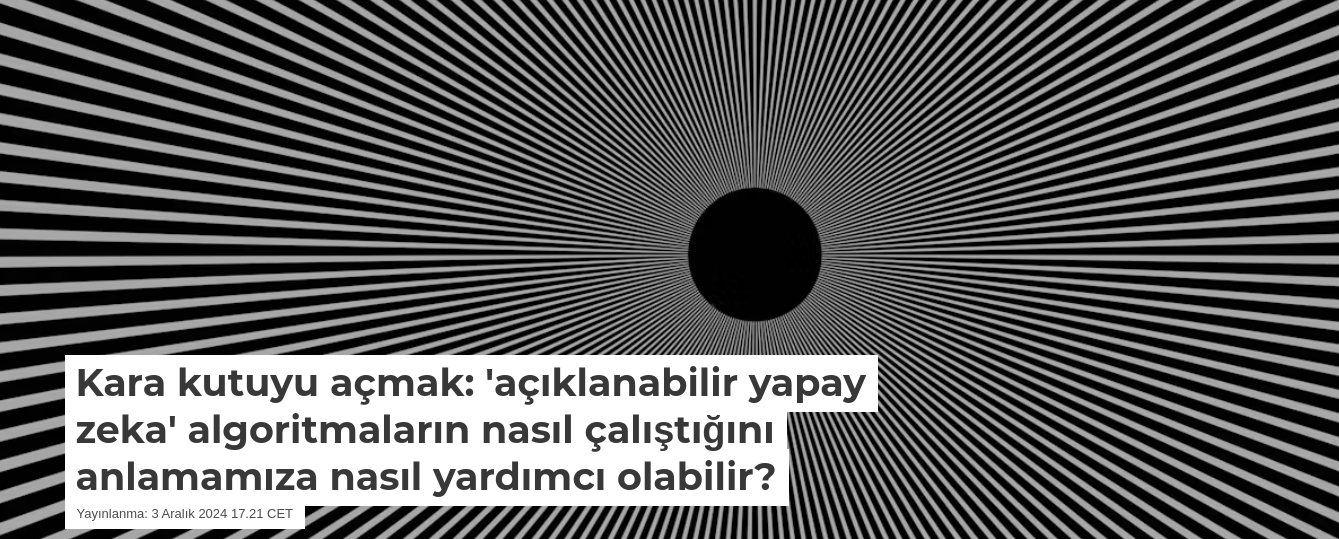

Ancak bu yapay zeka sistemlerinin ortak bir sorunu, iç işleyişlerinin anlaşılmasının genellikle karmaşık olmasıdır – sadece genel halk için değil, aynı zamanda uzmanlar için de! Bu, yapay zeka araçlarını pratikte nasıl kullanabileceğimizi sınırlar. Bu sorunu ele almak ve artan düzenleyici taleplere uyum sağlamak için “açıklanabilir yapay zeka” olarak bilinen bir araştırma alanı ortaya çıkmıştır.

Yapay zeka ve makine öğrenimi: Bir isimde ne var?

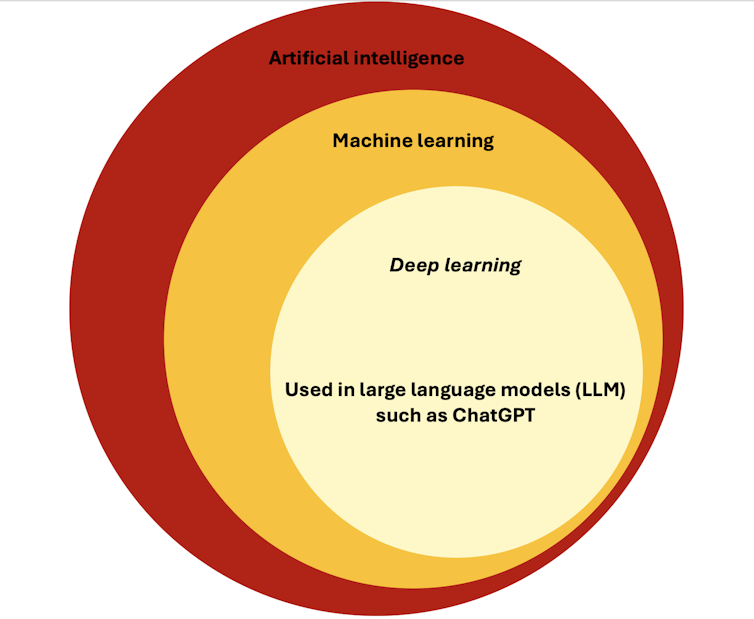

Yapay zekanın kuruluşlara entegrasyonuna yönelik mevcut hareket ve potansiyelinin yaygın bir şekilde medyatikleştirilmesiyle, özellikle makine öğrenimi, derin öğrenme ve büyük dil modelleri de dahil olmak üzere yapay zeka sistemlerini belirtmek için ortalıkta dolaşan pek çok terimle kafanızın karışması kolaydır.

Basit bir ifadeyle yapay zeka, problem çözme, karar verme ve dili anlama gibi insan zekası gerektiren görevleri yerine getiren bilgisayar sistemlerinin geliştirilmesini ifade eder. Robotik, bilgisayarla görme ve doğal dil anlama gibi çeşitli alt alanları kapsar.

Yapay zekanın önemli bir alt kümesi, bilgisayarların her görev için açıkça programlanmak yerine verilerden öğrenmesini sağlayan makine öğrenimidir. Esasen, makine verilerdeki kalıplara bakar ve bu kalıpları tahminler veya kararlar almak için kullanır. Örneğin, bir e-posta istenmeyen posta filtresini düşünün. Sistem, hem spam hem de spam olmayan e-postaların binlerce örneği ile eğitilmiştir. Zamanla, spam’de yaygın olan belirli kelimeler, ifadeler veya gönderen ayrıntıları gibi kalıpları öğrenir.

Makine öğreniminin bir başka alt kümesi olan derin öğrenme, daha da karmaşık kalıpları öğrenmek için birden çok katmana sahip karmaşık sinir ağlarını kullanır. Derin öğrenmenin, görüntü veya metinsel verilerle çalışırken olağanüstü bir değere sahip olduğu gösterilmiştir ve çeşitli görüntü tanıma araçlarının veya ChatGPT gibi büyük dil modellerinin temelini oluşturan temel teknolojidir.

Yapay zekayı düzenleme

Yukarıdaki örnekler, yapay zekanın farklı endüstrilerde geniş çapta uygulanmasını göstermektedir. Netflix’te film önermek gibi bu senaryoların birçoğu nispeten düşük riskli görünüyor. Bununla birlikte, işe alım, kredi puanlaması veya tıbbi teşhis gibi diğerleri, birinin hayatı üzerinde büyük bir etkiye sahip olabilir ve bu da bunların etik hedeflerimizle uyumlu bir şekilde gerçekleşmesini çok önemli hale getirir.

Bunu kabul eden Avrupa Birliği, parlamentosunun Mart ayında onayladığı AI Yasasını önerdi. Bu düzenleyici çerçeve, yapay zeka uygulamalarını toplum ve bireyler üzerindeki potansiyel etkilerine bağlı olarak kabul edilemez, yüksek, sınırlı ve minimum olmak üzere dört farklı risk seviyesine sınıflandırır. Her seviye farklı derecelerde düzenlemelere ve gereksinimlere tabidir.

Sosyal puanlama veya tahmine dayalı polislik için kullanılan sistemler gibi kabul edilemez riskli yapay zeka sistemleri, insan hakları için önemli tehditler oluşturdukları için AB’de yasaklanmıştır.

Yüksek riskli yapay zeka sistemlerine izin verilir, ancak kolluk kuvvetleri, işe alım ve eğitim gibi ortamlar da dahil olmak üzere başarısız olmaları veya kötüye kullanılmaları durumunda önemli zararlara neden olma potansiyeline sahip oldukları için en katı düzenlemelere tabidirler.

Sohbet robotları veya duygu tanıma sistemleri gibi sınırlı riskli yapay zeka sistemleri, bir miktar manipülasyon veya aldatma riski taşır. Burada insanların yapay zeka sistemi ile etkileşimleri hakkında bilgilendirilmesi önemlidir.

Minimum riskli yapay zeka sistemleri, ek kısıtlamalar olmadan dağıtılabilen spam filtreleri gibi diğer tüm yapay zeka sistemlerini içerir.

Açıklanabilirlik ihtiyacı

Birçok tüketici artık kararlarını kara kutu algoritmalarına bağlayan şirketleri kabul etmeye istekli değil. Bir erkeğin, ortak varlıklarına rağmen, karısından önemli ölçüde daha yüksek bir kredi limiti verildiği Apple Card olayını ele alalım. Apple, algoritmasının kararının arkasındaki mantığı açıklayamadığı için bu, halkın öfkesine yol açtı. Bu örnek, yalnızca müşteri memnuniyetini sağlamak için değil, aynı zamanda olumsuz kamuoyu algısını önlemek için yapay zeka odaklı kararlarda artan açıklanabilirlik ihtiyacını vurgulamaktadır.

Yüksek riskli YZ sistemleri için, YZ Yasası’nın 86. maddesi, YZ sistemleri tarafından alınan kararların açıklanmasını talep etme hakkını belirler ve bu, algoritmik şeffaflığın sağlanmasına yönelik önemli bir adımdır.

Bununla birlikte, yasal uyumluluğun ötesinde, şeffaf yapay zeka sistemleri hem model sahipleri hem de sistem kararlarından etkilenenler için başka avantajlar da sunar.

Şeffaf yapay zeka

İlk olarak, şeffaflık güven oluşturur: kullanıcılar bir yapay zeka sisteminin nasıl çalıştığını anladıklarında, onunla etkileşim kurma olasılıkları daha yüksektir. İkinci olarak, düzenleyicilerin bir modelin belirli grupları haksız yere kayırıp ayırmadığını doğrulamasına olanak tanıyarak önyargılı sonuçları önleyebilir. Son olarak şeffaflık, hataları veya beklenmedik kalıpları ortaya çıkararak yapay zeka sistemlerinin sürekli iyileştirilmesini sağlar.

Peki yapay zekada şeffaflığı nasıl sağlayabiliriz?

Genel olarak, yapay zeka modellerini daha şeffaf hale getirmek için iki ana yaklaşım vardır.

İlk olarak, tahminlerde bulunmak için karar ağaçları veya doğrusal modeller gibi basit modeller kullanılabilir. Karar verme süreçleri basit olduğu için bu modellerin anlaşılması kolaydır. Örneğin, yatak odası sayısı, metrekare ve konum gibi özelliklere dayalı olarak ev fiyatlarını tahmin etmek için doğrusal bir regresyon modeli kullanılabilir. Basitlik, her özelliğe bir ağırlık atanması ve tahminin basitçe bu ağırlıklı özelliklerin toplamı olması gerçeğinde yatmaktadır. Bu, her bir özelliğin nihai ev fiyat tahminine nasıl katkıda bulunduğunu açıkça görebileceğiniz anlamına gelir.

Ancak, veriler daha karmaşık hale geldikçe, bu basit modeller artık yeterince iyi performans göstermeyebilir.

Bu nedenle geliştiriciler genellikle daha büyük ve daha karmaşık verileri işleyebilen ancak yorumlanması zor olan derin sinir ağları gibi daha gelişmiş “kara kutu modellerine” yönelir. Örneğin, milyonlarca parametreye sahip derin bir sinir ağı çok yüksek bir performans elde edebilir, ancak kararlarına ulaşma şekli insanlar tarafından anlaşılabilir değildir, çünkü karar verme süreci çok büyük ve karmaşıktır.

Açıklanabilir Yapay Zeka

Başka bir seçenek de, modeli veya kararlarını netleştirmek için bu güçlü kara kutu modellerini ayrı bir açıklama algoritmasıyla birlikte kullanmaktır. “Açıklanabilir yapay zeka” olarak bilinen bu yaklaşım, bir miktar şeffaflık sunarken karmaşık modellerin gücünden yararlanmamızı sağlar.

İyi bilinen bir yöntem, karşı olgusal açıklamadır. Karşı olgusal bir açıklama, girdi özelliklerinde farklı bir karara yol açacak minimum değişiklikleri belirleyerek bir modelin kararını açıklar.

Örneğin, bir yapay zeka sistemi birine kredi vermeyi reddederse, karşı olgusal bir açıklama başvuru sahibini bilgilendirebilir: “Geliriniz 5.000 $ daha yüksek olsaydı, krediniz onaylanırdı“. Bu, kararı daha anlaşılır hale getirirken, kullanılan makine öğrenimi modeli hala çok karmaşık olabilir. Bununla birlikte, bir dezavantajı, bu açıklamaların yaklaşık olmasıdır, bu da aynı kararı açıklamanın birden fazla yolu olabileceği anlamına gelir.

Önümüzdeki yol

Yapay zeka modelleri giderek daha karmaşık hale geldikçe, dönüştürücü etki potansiyelleri de artar – ancak hata yapma kapasiteleri de artar. Yapay zekanın gerçekten etkili ve güvenilir olması için kullanıcıların bu modellerin kararlarına nasıl ulaştığını anlamaları gerekir.

Şeffaflık sadece bir güven inşa etme meselesi değil, aynı zamanda hataları tespit etmek ve adaleti sağlamak için de çok önemlidir. Örneğin, kendi kendini süren arabalarda, açıklanabilir yapay zeka, mühendislerin arabanın neden bir dur işaretini yanlış yorumladığını veya bir yayayı tanıyamadığını anlamalarına yardımcı olabilir. Benzer şekilde, işe alımda, bir yapay zeka sisteminin iş adaylarını nasıl sıraladığını anlamak, işverenlerin önyargılı seçimlerden kaçınmasına ve çeşitliliği teşvik etmesine yardımcı olabilir.

Şeffaf ve etik yapay zeka sistemlerine odaklanarak, teknolojinin hem bireylere hem de topluma olumlu ve adil bir şekilde hizmet etmesini sağlayabiliriz.

Kaynak:theconversation.com

+ There are no comments

Add yours